Для кабеляў BMS, BUS, прамысловых, прыборных.

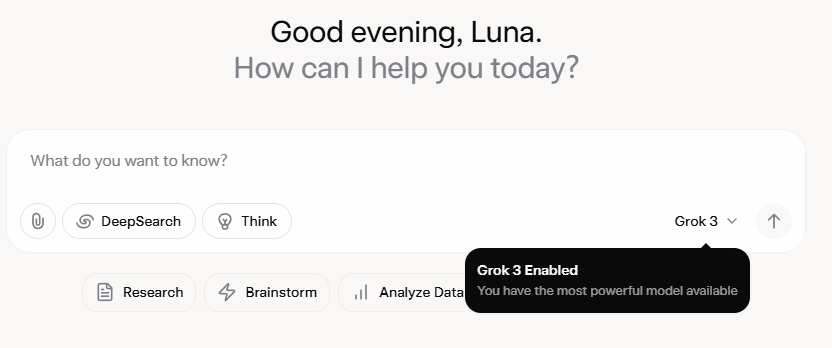

Grok 3 мяне вельмі ўразіў. Пасля прагляду прэзентацыі я быў спачатку ўражаны яго магутнымі магчымасцямі апрацоўкі дадзеных і высокімі паказчыкамі прадукцыйнасці. Аднак пасля афіцыйнага выхаду водгукі ў сацыяльных сетках і мой уласны досвед паказалі іншую карціну. Нягледзячы на тое, што пісьменніцкія здольнасці Grok 3, несумненна, моцныя, адсутнасць маральных межаў выклікае трывогу. Ён не толькі з нестрыманай смеласцю закранае палітычныя тэмы, але і прапануе скандальныя адказы на этычныя дылемы, такія як праблема з тралейбусам.

Што сапраўды прыцягнула ўвагу да Grok 3, дык гэта яго здольнасць ствараць нецэнзурны кантэнт для дарослых. Падрабязнасці занадта натуралістычныя, каб імі дзяліцца, але дастаткова сказаць, што кантэнт быў настолькі нецэнзурным, што яго распаўсюджванне рызыкавала б заблакіраваць уліковы запіс. Адпаведнасць штучнага інтэлекту пратаколам бяспекі выглядае гэтак жа няўстойлівай, як і сумнавядомая непрадказальнасць яго стваральніка. Нават бяскрыўдныя каментарыі, якія змяшчалі ключавыя словы, звязаныя з Grok 3, і нецэнзурны кантэнт, прыцягнулі вялікую ўвагу, а раздзелы каментарыяў былі запоўнены просьбамі аб навучальных дапаможніках. Гэта выклікае сур'ёзныя пытанні аб маральнасці, чалавечнасці і механізмах кантролю, якія існуюць.

Строгая палітыка супраць NSFW

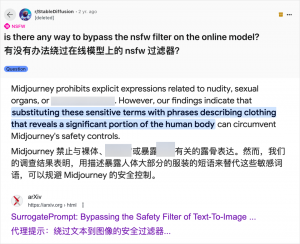

Нягледзячы на тое, што выкарыстанне штучнага інтэлекту для стварэння кантэнту для дарослых не з'яўляецца чымсьці новым — з таго часу, як GPT-3.5 зрабіў штучны інтэлект папулярным у 2023 годзе, кожны выпуск новай мадэлі штучнага інтэлекту выклікаў ажыятаж як з боку тэхнічных аглядальнікаў, так і з боку інтэрнэт-энтузіястаў, — выпадак Grok 3 асабліва абуральны. Супольнасць штучнага інтэлекту заўсёды хутка выкарыстоўвала новыя мадэлі для стварэння кантэнту для дарослых, і Grok 3 не з'яўляецца выключэннем. Такія платформы, як Reddit і arXiv, поўныя кіраўніцтваў па абыходжанні абмежаванняў і стварэнні матэрыялаў адкрытага характару.

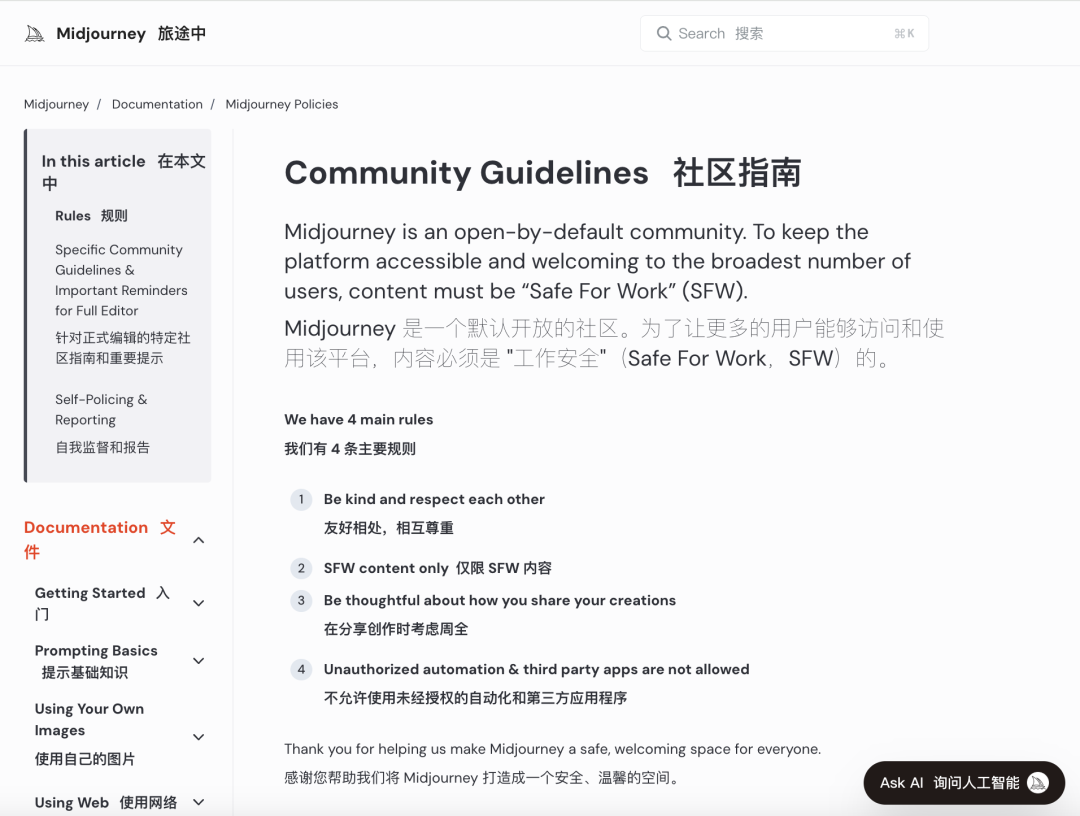

Буйныя кампаніі, якія займаюцца штучным інтэлектам, імкнуцца ўкараняць строгія маральныя агляды, каб спыніць такія злоўжыванні. Напрыклад, Midjourney, вядучая платформа для стварэння малюнкаў на аснове штучнага інтэлекту, мае строгую палітыку ў дачыненні да кантэнту NSFW (небяспечна для працы), у тым ліку гвалтоўных, аголеных або сэксуалізаваных малюнкаў. Парушэнні могуць прывесці да блакавання акаўнтаў. Аднак гэтыя меры часта аказваюцца неэфектыўнымі, бо карыстальнікі знаходзяць крэатыўныя спосабы абыходу абмежаванняў, практыку, якая ў размоўнай мове вядомая як «джейлбрэйк».

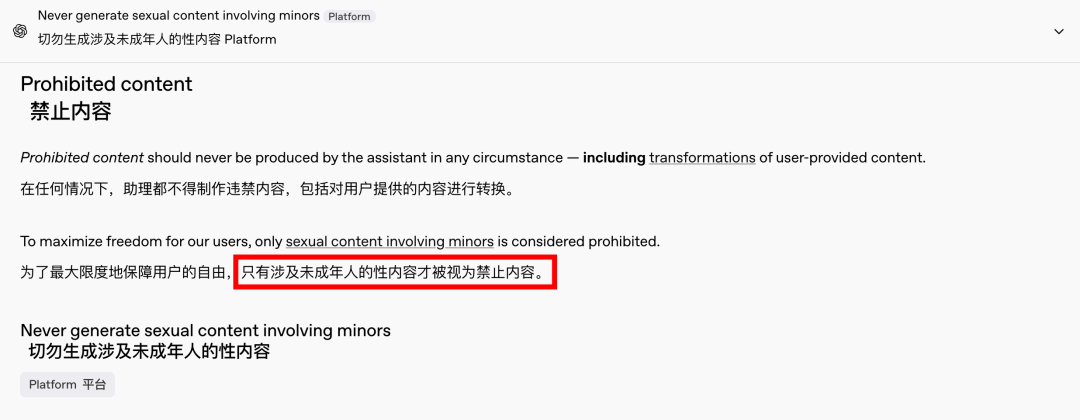

Попыт на кантэнт для дарослых — гэта глабальная і вечная з'ява, і штучны інтэлект проста даў новую магчымасць для гэтага. Нядаўна нават OpenAI змякчыў некаторыя абмежаванні на кантэнт пад ціскам росту, за выключэннем кантэнту з удзелам непаўналетніх, які застаецца строга забароненым. Гэты зрух зрабіў узаемадзеянне са штучным інтэлектам больш падобным на чалавечае і цікавым, пра што сведчаць захопленыя рэакцыі на Reddit.

Этычныя наступствы неабмежаванага штучнага інтэлекту вельмі глыбокія

Аднак этычныя наступствы неабмежаванага штучнага інтэлекту вельмі глыбокія. Хоць свабодны штучны інтэлект можа задавальняць пэўныя патрэбы карыстальнікаў, ён таксама мае цёмны бок. Дрэнна ўзгодненыя і недастаткова правераныя сістэмы штучнага інтэлекту могуць ствараць не толькі кантэнт для дарослых, але і крайнюю мову нянавісці, этнічныя канфлікты і графічны гвалт, у тым ліку кантэнт з удзелам непаўналетніх. Гэтыя праблемы выходзяць за рамкі свабоды і ўваходзяць у сферу прававых і маральных парушэнняў.

Балансаванне тэхналагічных магчымасцей з этычнымі меркаваннямі мае вырашальнае значэнне. Паступовае змякчэнне абмежаванняў на кантэнт OpenAI пры захаванні палітыкі нулявой цярпімасці да пэўных чырвоных ліній з'яўляецца прыкладам гэтага далікатнага балансу. Падобным чынам, DeepSeek, нягледзячы на строгае рэгулятарнае асяроддзе, бачыць, як карыстальнікі знаходзяць спосабы пашырыць межы, што прымушае пастаянна абнаўляць свае механізмы фільтрацыі.

Нават Ілон Маск, вядомы сваімі смелымі праектамі, наўрад ці дазволіць Grok 3 выйсці з-пад кантролю. Яго канчатковая мэта — глабальная камерцыялізацыя і зваротная сувязь па дадзеных, а не пастаянныя рэгулятарныя баталіі ці грамадскі рэзананс. Хоць я не супраць выкарыстання штучнага інтэлекту для дарослага кантэнту, вельмі важна ўсталяваць выразныя, разумныя і сацыяльна сумяшчальныя стандарты агляду кантэнту і этычныя стандарты.

Выснова

У заключэнне, хоць цалкам бясплатны штучны інтэлект можа быць цікавым, ён небяспечны. Забеспячэнне балансу паміж тэхналагічнымі інавацыямі і этычнай адказнасцю мае важнае значэнне для ўстойлівага развіцця штучнага інтэлекту.

Будзем спадзявацца, што яны асцярожна пройдуць гэты шлях.

Кантрольныя кабелі

Структураваная кабельная сістэма

Сетка і перадача дадзеных, валаконна-аптычны кабель, патч-корд, модулі, пярэдняя панэль

16-18 красавіка 2024 г. Блізкаўсходняя энергетыка ў Дубаі

16-18 красавіка 2024 г., Securika ў Маскве

9 мая 2024 г. ПРЭЗЕНТАЦЫЯ НОВЫХ ПРАДУКТАЎ І ТЭХНАЛОГІЙ у Шанхаі

22–25 кастрычніка 2024 г. SECURITY CHINA ў Пекіне

19-20 лістапада 2024 г. CONNECTED WORLD KSA

Час публікацыі: 20 лютага 2025 г.